De techgemeenschap blijft in de ban van de voortdurende strijd tussen GPU-titanen op het gebied van high-performance computing (HPC), waar snelheid en efficiëntie van het grootste belang zijn. NVIDIA's Tensor Core GPU's, die voorop lopen in deze hevige concurrentiestrijd, hebben het landschap gerevolutioneerd, de grenzen van rekenkracht verlegd en nieuwe horizonten geopend voor wetenschappelijk onderzoek, kunstmatige intelligentie en data-intensieve toepassingen.

In deze blog duiken we in de spannende krachtmeting tussen twee prominente NVIDIA GPU's, de A100 en de H100, waarbij we hun unieke mogelijkheden belichten en het belang van hun vergelijking onderzoeken. Deze baanbrekende GPU's hebben opnieuw gedefinieerd wat mogelijk is in HPC en maken gebruik van geavanceerde technologieën om ongekende prestaties en schaalbaarheid te bieden.

NVIDIA A100 vs H100 Vergelijkingstabel technische specificaties

| Functie | NVIDIA A100 | NVIDIA H100 |

|---|---|---|

| Architectuur | Ampère | Vultrechter |

| CUDA-kernen | 6,912 | 18,432 |

| Tensor-kernen | 432 (3e generatie) | 640 (4e generatie) met transformatormotor |

| Geheugen | 40 GB / 80 GB HBM2e | 80 GB HBM3 |

| Bandbreedte geheugen | 2,0 TB/s | 3,35 TB/s |

| FP32 prestaties | ~19,5 TFLOPS | ~51 TFLOPS |

| Prestaties FP8 | Niet ondersteund | Meer dan 2.000 TFLOPS |

| NVLink | NVLink 3.0 (600 GB/s) | NVLink 4.0 (900 GB/s) |

| Multi-Instance GPU (MIG) | 1e generatie MIG (tot 7 instanties) | 2e generatie MIG |

| PCIe stroomverbruik | ~250W | ~350W |

| Stroomverbruik SXM | ~400W | ~700W |

NVIDIA A100 specificaties en mogelijkheden

De NVIDIA A100, gebaseerd op de Ampere-architectuur, biedt aanzienlijke verbeteringen ten opzichte van de vorige Volta-generatie. De A100 is uitgerust met 6.912 CUDA-kernen, 432 Tensor Cores van de derde generatie en 40 GB of 80 GB HBM2e-geheugen met hoge bandbreedte en is ontworpen voor krachtige AI-workloads. Het biedt tot 20× snellere prestaties in vergelijking met eerdere GPU's in specifieke mixed-precision taken.

Benchmarkresultaten benadrukken de kracht in deep learning-toepassingen, waaronder beeldherkenning, natuurlijke taalverwerking (NLP) en spraakherkenning.

Een belangrijke innovatie in de Ampere-architectuur is de derde generatie Tensor Cores, geoptimaliseerd voor matrixbewerkingen met hoge doorvoer met formaten als TF32 en FP16. De A100 introduceert ook NVIDIA Multi-Instance GPU (MIG) technologie, waardoor een enkele GPU kan worden gepartitioneerd in maximaal zeven geïsoleerde instanties.

NVIDIA H100 specificaties en mogelijkheden

De NVIDIA H100 GPU, gebouwd op de Hopper architectuur, levert geavanceerde prestaties voor AI en HPC workloads. Hij beschikt over 18.432 CUDA-kernen, 640 Tensor Cores van de vierde generatie en 80 Streaming Multiprocessors (SM's). De H100 levert tot 51 teraflops FP32-prestaties en meer dan 2.000 teraflops met FP8-precisie.

Het integreert NVLink 4.0 voor tot 900 GB/s aan GPU-naar-GPU bandbreedte en ondersteunt next-gen workloads zoals grote taalmodellen en diepe neurale netwerken.

In benchmarks zoals MLPerf presteert de H100 aanzienlijk beter dan de A100 en V100.

Vergelijking prestatiebenchmarks (MLPerf of op werklast gebaseerd)

| Type werkbelasting | A100 prestaties | H100 prestaties | Verbetering |

|---|---|---|---|

| BERT-inferentie | 1× | 3.5-4× | Tot 4× |

| GPT-3 Opleiding | 1× | 2-3× | 2-3× |

| ResNet-50 Opleiding | 1× | 2.2× | 2.2× |

| Wetenschappelijke simulatie (FP64) | 1× | 2× | 2× |

Bouwkundige verschillen tussen A100 en H100

De A100 gebruikt HBM2e geheugen (40/80 GB) met 2,0 TB/s bandbreedte. De H100 gaat naar HBM3 (80 GB) en 3,35 TB/s bandbreedte. De H100 bevat Tensor Cores van de vierde generatie en FP8-precisie, aangedreven door een Transformer Engine.

Beide ondersteunen MIG, maar de 2e generatie MIG van de H100 biedt betere isolatie en efficiëntie.

Vergelijking van energie-efficiëntie

De H100 GPU verbruikt meer stroom dan de A100 - tot 700 W in SXM vormfactor tegenover 400 W voor de A100. Dit hogere stroomverbruik gaat echter gepaard met aanzienlijk betere prestaties, met name in werklasten die zijn geoptimaliseerd voor FP8 precisie en de Transformer Engine.

Bij het vergelijken van prestaties-per-watt met behulp van gestandaardiseerde benchmarks zoals MLPerf (bijvoorbeeld ResNet-50 training), levert de H100 ongeveer 60% meer efficiëntie dan de A100. Dit betekent dat de H100 weliswaar meer energie verbruikt, maar ook meer werk verricht per eenheid verbruikt vermogen.

Op het gebied van koeling vereist de H100 robuuster thermisch beheer vanwege de hogere vermogensdichtheid, maar moderne datacenters zijn hier over het algemeen op ingericht. De efficiëntiewinst rechtvaardigt de extra koelvereisten in omgevingen met hoge prestaties.

Beste gebruiksscenario's (tabelweergave)

| Type gebruikssituatie | Beste keuze | Waarom |

|---|---|---|

| Algemene diepte-leertraining | A100 | Sterke prestaties, kosteneffectief |

| Training van grote taalmodellen | H100 | FP8 + Transformator, uitstekende verwerkingscapaciteit |

| Real-time inferentie | H100 | Snelle geheugentoegang met lage latentie |

| Wetenschappelijke simulaties | H100 | Betere FP64 en bandbreedte |

| Budgetbewuste AI-projecten | A100 | Betaalbaarder, overal verkrijgbaar |

| Omgevingen met meerdere huurders | Beide | H100 heeft betere MIG; A100 is zuiniger |

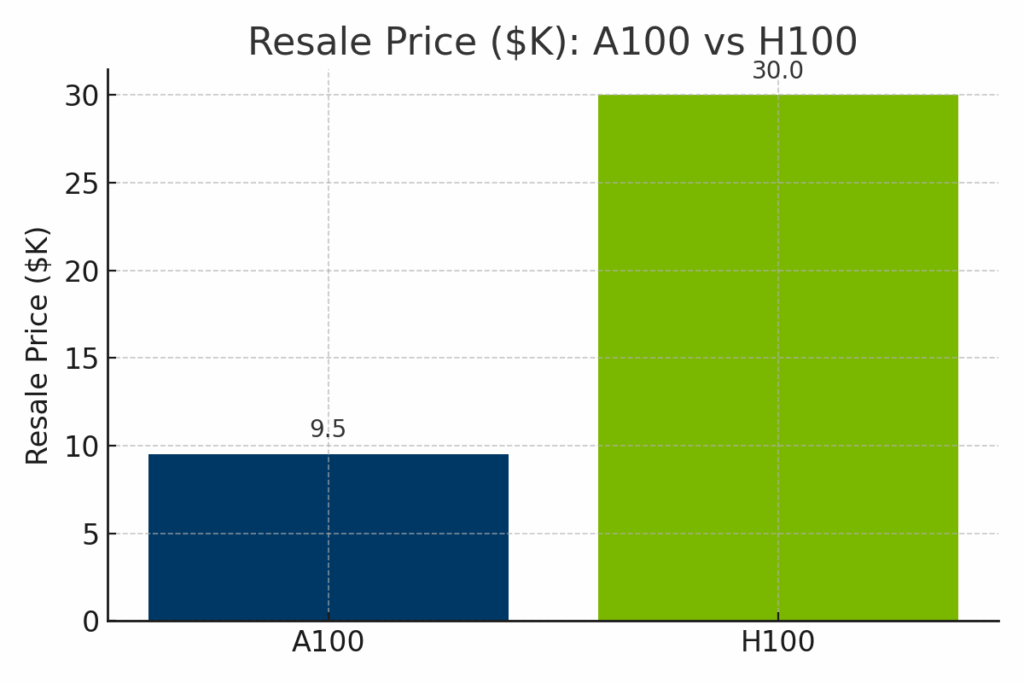

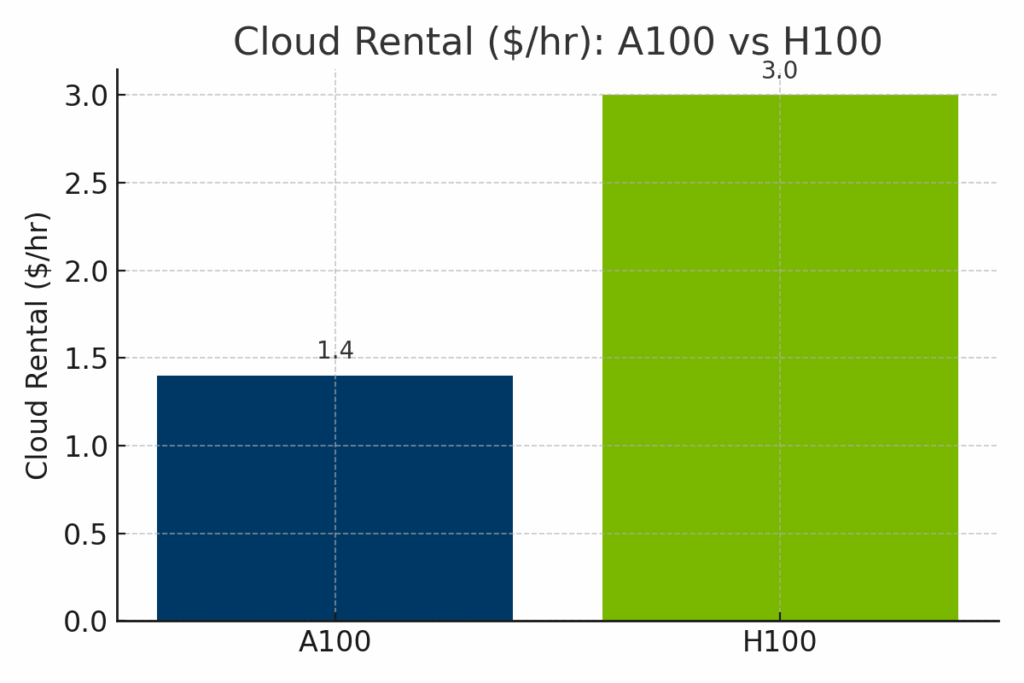

Prijs- en beschikbaarheidsvergelijking A100 vs H100

Hoewel de H100 duidelijk beter presteert dan de A100 op het gebied van brute rekenkracht, zijn de kosten ook aanzienlijk hoger, zowel wat betreft de doorverkoopwaarde van de hardware als de uurtarieven voor cloudhuur. Om de afweging tussen kosten en mogelijkheden te illustreren, wordt in de volgende visuele vergelijkingen uitgesplitst hoe de A100 en H100 zich verhouden tot drie belangrijke dimensies: wederverkoopprijzen, cloud implementatiekosten en genormaliseerde AI-prestaties.

Figuur: Geschatte doorverkoopwaarde van de NVIDIA A100 vs H100 in 2025. De H100 heeft een aanzienlijk hogere doorverkoopprijs - gemiddeld ongeveer $30.000 - vanwege zijn nieuwere architectuur en geavanceerde prestaties, terwijl de A100 doorgaans wordt verkocht voor $9.000-$12.000.

Figuur: Uurlijkse cloud-huurtarieven voor A100 en H100 GPU's bij grote providers. H100-instanties kosten aanzienlijk meer - vaak rond $3,00/uur - in vergelijking met het gemiddelde van $1,40/uur voor A100, wat de verbeterde AI-doorvoer en de nieuwere vraag naar infrastructuur van de H100 weerspiegelt.

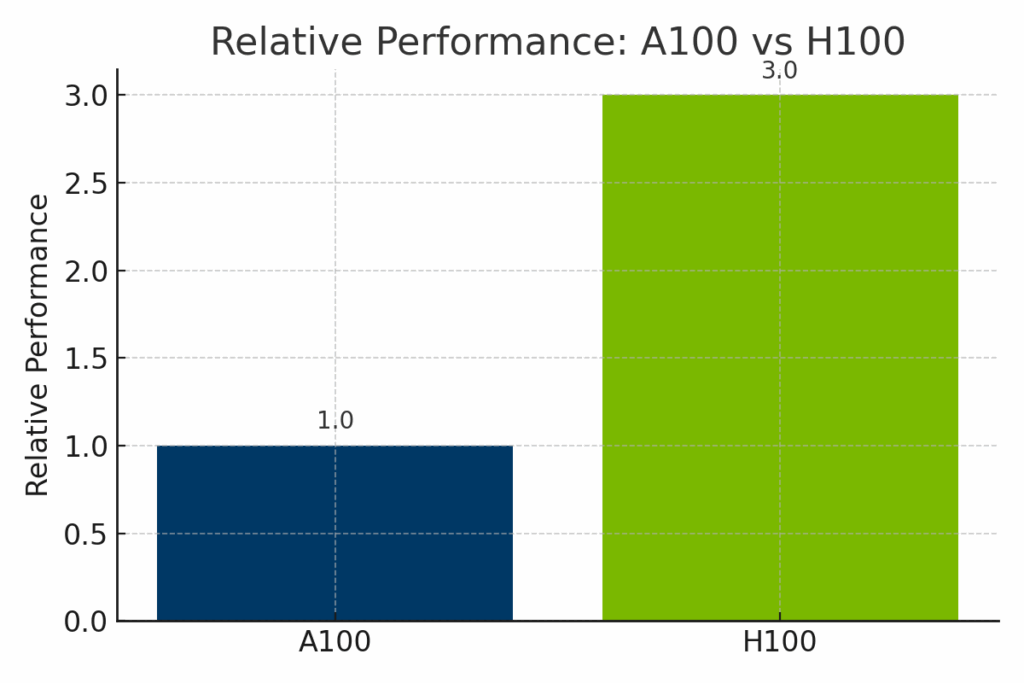

Figuur: Genormaliseerde prestaties van de NVIDIA A100 en H100 bij AI-workloads. De H100 levert tot 3× de prestaties van de A100, met name in transformer-gebaseerde modellen en FP8-geoptimaliseerde training, waardoor deze ideaal is voor geavanceerde ondernemings-AI.

NVIDIA-roadmap en toekomstige ontwikkelingen

NVIDIA's toekomstige GPU's, gebaseerd op de aankomende Blackwell-architectuur (bv. B100, B200), zullen naar verwachting een nog grotere computerdichtheid en geheugenverbeteringen bieden.

NVIDIA's softwareplatforms zoals CUDA, TensorRT en AI Enterprise worden actief onderhouden om nieuwe werklasten te ondersteunen.

Software-ecosysteem en ondersteuning voor ontwikkelaars

Beide GPU's worden ondersteund in CUDA, cuDNN, cuBLAS, TensorRT en populaire frameworks zoals PyTorch, TensorFlow en JAX.

H100 profiteert van verbeterde FP8-ondersteuning en Transformer Engine-optimalisatie binnen deze ecosystemen. Ontwikkelaars kunnen gebruik maken van vooraf gebouwde containers op NVIDIA NGC en robuuste documentatie via het NVIDIA Developer Program.

Samenvatting van voor- en nadelen

| Categorie | NVIDIA A100 | NVIDIA H100 |

|---|---|---|

| Voordelen | Kosteneffectief, betrouwbaar, sterk voor standaard AI/HPC | Beste prestaties, FP8, superieur voor LLM's en real-time inferentie |

| Nadelen | Mist nieuwere AI-functies (bijv. FP8, Transformer Engine) | Hogere kosten, energie-intensief, mogelijk een upgrade van de infrastructuur nodig |

| Ideaal voor | Budgetbewuste teams, traditionele HPC, schalen in de cloud | Geavanceerde AI-werklasten, generatieve AI, bedrijfsimplementaties |

Kiezen tussen A100 en H100 voor AI-werklasten

De keuze tussen de A100 en H100 hangt af van je doelen, budget en use case. A100 is kostenefficiënt en nog steeds krachtig voor veel AI/HPC-taken. H100 is een krachtpatser die klaar is voor de toekomst en gebouwd is voor de meest veeleisende werklasten.

Als je een upgrade uitvoert naar een nieuwere GPU zoals de H100, overweeg dan om je oude hardware te verkopen aan exIT Technologies. Wij bieden veilige en efficiënte diensten voor het terugwinnen van activa waarmee u waarde kunt terugwinnen en uw gepensioneerde infrastructuur op verantwoorde wijze kunt beheren.